Гайд: Лучшие практики при настройке robots.txt и тегов meta robots в 2020 году

Таким вещам как robots.txt традиционно уделяется не так много времени, так как создается впечатление, что «и так все ясно». Тем не менее, именно проблемы настройки этого файла могут существенно влиять на ваше SEO.

Терминология типа «meta robots tags» или «robots.txt» для многих людей звучит как что-то футуристичное и крайне «диджитально-программное». В первую очередь, так это звучит для клиентов, которые заказывают SEO-услуги впервые. Цель этого материала – помочь разобраться в особенностях этих инструментов и сделать настройку meta robots tags и файла robots.txt на вашем сайте более понятной и эффективной.

meta robots tags VS robots.txt

Прежде, чем мы перейдем к детальному разбору, не лишним во избежание холивара будет отметить, что для использования в SEO один подход ничем не лучше и не хуже другого. Разница в подходе:

- robots.txt — файл, который сообщает поисковым системам обо всем, что есть на сайте, являяесь общим указателем для поведения робота поисковика

- meta robots — теги, которые сообщают роботу подробную информацию по каждой конкретной странице

Условная половина SEO-специалистов предпочитает использовать теги meta robots, вторая же половина работает «по классике», используя файл robots.txt. В чем же тогда их различие?

Что такое robots.txt?

Файл robots.txt сообщает поисковым роботам (web crawlers) что следует и что не следует сканировать на сайте. Этот файл – часть Протокола исключений для роботов (robots exclusion protocol или же просто REP).

Googlebot является примером поискового робота. Google использует Googlebot для сканирования сайтов и сохранения информации о их наполнении. На основе этих данных и внутренних алгоритмов, Google принимает решение как ранжировать ваш сайт в поисковой выдаче.

Файл robots.txt вы можете найти практически на любом сайте добавив /robots.txt к адресу сайта. Вот так выглядит базовый файл robots.txt:

User-agent: * Disallow: /

«Звездочка» * после User-agent: сообщает поисковому роботу, что файл robots.txt предназначен для всех поисковых роботов, которые хотят просканировать сайт. Слеш / после Disallow: сообщает роботу, что вы не хотите, чтобы он посещал любые страницы на вашем сайте. Итого интерпретация синтаксиса такова: запрещаю индексировать этот сайт кому-угодно. Внимание, это не гарантия того, что Google послушается вас и не просканирует страницу. Действительно надежным вариантом защиты от поискового робота является лишь блокирование доступа к сайту по паролю или на серверном уровне.

Пример файла robots.txt на сайте компании Moz, одного из лидеров мирового рынка SEO:

Sitemap: https://moz.com/sitemaps-1-sitemap.xml Sitemap: https://moz.com/blog-sitemap.xml User-agent: * Allow: /researchtools/ose/$ Allow: /researchtools/ose/dotbot$ Allow: /researchtools/ose/links$ Allow: /researchtools/ose/just-discovered$ Allow: /researchtools/ose/pages$ Allow: /researchtools/ose/domains$ Allow: /researchtools/ose/anchors$ Allow: /products/ Allow: /local/ Allow: /learn/ Allow: /researchtools/ose/ Allow: /researchtools/ose/dotbot$ Disallow: /products/content/ Disallow: /local/enterprise/confirm Disallow: /researchtools/ose/ Disallow: /page-strength/* Disallow: /thumbs/* Disallow: /api/user?* Disallow: /checkout/freetrial/* Disallow: /local/search/ Disallow: /local/details/ Disallow: /messages/ Disallow: /content/audit/* Disallow: /content/search/* Disallow: /marketplace/ Disallow: /cpresources/ Disallow: /vendor/ Disallow: /community/q/questions/*/view_counts Disallow: /admin-preview/*

Robots файл сайта Moz сообщает поисковым роботам какие страницы он разрешает сканировать, а какие запрещает. Это в общих чертах, но перейдем к деталям, так как именно они важны в рамках сегодняшнего разбора.

Почему robots.txt важен?

Блокирование поисковых роботов. Уверены, вы не раз сталкивались с тем, что через пару месяцев после запуска нового сайта или переноса старого, вы задавались вопросом: «Почему сайт не ранжируется?».

Практика показывает, что в более чем в половине случаев причина простая – плохо настроенный файл robots.txt. Зачастую, он все еще выглядит вот так:

User-agent: * Disallow: /

Подобные базовые настройки блокируют поисковых роботов, посещающих сайт.

Crawl Budget или Бюджет обхода. Вторая причина, по которой важен файл robots.txt – это Crawl Budget самого Google. Google заявляет:

«Googlebot разработан таким образом, чтобы быть тем самым «классным парнем» в интернете. Сканирование – его основной приоритет. Он следит за тем, чтобы на сайтах не ухудшался пользовательский опыт. Мы называем это – crawl rate limit (ограничение скорости прохода). Этот показатель указывает на максимальную скорость прохода по данному сайту.

Проще говоря, это число одновременных параллельных подключений, которые Googlebot может использовать для сканирования сайта, а также время ожидания ответа между запросами».

Если у вас крупный сайт с кучей некачественных с точки зрения SEO страниц, которые вы не хотите показывать поисковым роботам, можно просто указать их в файле robots.txt, используя команду Disallow.

Такое действие сделает Crawl Budget сайта посвободней и Googlebot отсканирует только те страницы, которые уже качественно подготовлены. То есть, Google будет оценивать только разрешенные страницы при ранжировании сайта. Кстати! В июле 2019 года Google предложил внедрить общие стандарты для robots.txt. Но пока что никаких строгих правил и ограничений введено не было, потому рынок и сегодня продолжает следовать лучшим практикам предыдущих лет.

Основы работы с robots.txt

Однажды изучив все аспекты функционирования robots.txt, вы более не будете терять время, месяцами ожидая улучшений после очередных усилий по росту трафика. Ведь в половине таких случаев ошибка заключается не в вашей SEO-стратегии, а технических ограничениях, до которых часто никому нет дела. Ниже приведены общие команды robots.txt, с которыми стоит быть «на ты»:

User-agent: * – это первая строка в вашем файле robots.txt, объясняющая поисковым роботам, что ваш сайт готов к сканированию. Звездочка информирует, что сайт открыт для сканирования поисковыми роботами любых систем, будь то Google, Bing или другой поисковик.

User-agent: Googlebot – сообщает роботам о том, что вы хотели бы сканировать ваш сайт только роботом Google.

Disallow: / – сообщает роботам, что весь ваш сайт пока запрещен к индексации.

Disallow: – весь ваш сайт готов к сканированию (все страницы).

Disallow: /somefolder/ – просит поисковые роботы игнорировать конкретную папку

Disallow: /uploads/* .pdf – просит поисковые роботы игнорировать все файлы в формате PDF в директории /uploads/ (выберите любую) во избежание дублирования контента.

Создание robots.txt на сайтах WordPress

Если ваш сайт создан на WordPress, самый простой способ создать robots.txt – бесплатная версия плагина Yoast. Этот плагин также будет полезен для настройки других важных SEO-параметров. Формируя robots.txt для конкретного проекта, учитывайте следующее:

1. Формируйте ваш robots.txt корректно. Отличный пример – файл robots.txt у SEMrush, еще одного мирового лидера на рынке SEO.

В структуре файла использован паттерн User-agent → Disallow → Allow → Host → Sitemap, который позволяет поисковым роботам сканировать рубрики и страницы сайта в правильном порядке.

Disallow: / User-agent: Semrushbot-SA Allow: / User-agent: Semrushbot-SI Allow: / User-agent: Yahoo Pipes 2.0 Disallow: / User-agent: Googlebot Disallow: /blog/*?img=* Disallow: /archive/graphs.php Disallow: /partner/ User-agent: Facebot Disallow: /archive/graphs.php User-agent: Bingbot Disallow: /archive/graphs.php User-agent: BingPreview Disallow: /archive/graphs.php User-agent: Twitterbot Allow: /blog/* Allow: /ranking-factors/* Allow: /forrester-marketing-silos/*

2. Убедитесь, что каждый URL к которому вы хотите разрешить или запретить доступ поисковым роботам, корректно внесен отдельными строками (без пробелов) в Allow и Disallow. Пример – файл robots.txt у BestBuy.

User-agent: * Disallow: /nex/ Disallow: /m/e/* Disallow: /site/builder/* Disallow: /site/olspage.jsp?id=pcat17098* Disallow: /site/olstemplatemapper.jsp?id=pcat17098* Disallow: /site/olspage.jsp?id=pcat17089* Disallow: /site/olstemplatemapper.jsp?id=pcat17089* Disallow: /site/olspage.jsp?id=cat13503* Disallow: /site/olstemplatemapper.jsp?id=cat13503* Disallow: /site/olspage.jsp?id=pcat17007* Disallow: /site/olstemplatemapper.jsp?id=pcat17007* Disallow: /site/olspage.jsp?id=pcat17408* Disallow: /site/olstemplatemapper.jsp?id=pcat17408* Disallow: /site/olspage.jsp?id=cat12091* Disallow: /site/olstemplatemapper.jsp?id=cat12091* Disallow: /site/olspage.jsp?id=pcat17005* Disallow: /site/olstemplatemapper.jsp?id=pcat17005* Disallow: /site/olspage.jsp?id=cat12076* Disallow: /site/olstemplatemapper.jsp?id=cat12076* Disallow: /site/olspage.jsp?id=cat12080* Disallow: /site/olstemplatemapper.jsp?id=cat12080* Disallow: /site/olspage.jsp?id=cat12101* Disallow: /site/olstemplatemapper.jsp?id=cat12101* Disallow: /site/olstemplatemapper.jsp?id=pcat17006* Disallow: /site/olspage.jsp?id=pcat17006* Disallow: /browse-api/* Disallow: /site/clp/test-pages/* Disallow: /site/test-pages/* Disallow: /site/misc/test-pages/* Disallow: /site/offer/* Disallow: /site/compare?skus=* Disallow: /api/*.json Disallow: /availability/* Disallow: /cart Disallow: /cart/* Disallow: /cartitems/* Disallow: /fulfillment/* Disallow: /location/* Disallow: /pricing/* Disallow: /productfulfillment/* Disallow: /profile/* Disallow: /*template=_gameDetailsTab Disallow: /*template=_movieDetailsTab Disallow: /*template=_musicDetailsTab Disallow: /*template=_softwareDetailsTab Disallow: /*template=_accessoriesTab Disallow: /*template=_castAndCrewTab Disallow: /*template=_editorialTab Disallow: /*template=_episodesTab Disallow: /*template=_protectionAndServicesTab Disallow: /*template=_specificationsTab Disallow: /*template=_featuresSpoke Disallow: /*template=_buyingOptionsNewTab Disallow: /*/pcmcat208500050016.c* Disallow: /site/modals/* Disallow: /site/clp/conditional-offers/* Disallow: /site/total-tech-support/* Disallow: /site/clp/annette-test-listing/* Disallow: /site/shop-view-test-page/* Disallow: /site/clp/test/* Disallow: /site/test-cloud-ready/* Disallow: /site/clp/mystery-rewards-certificate/pcmcat1524134875052.c?id=pcmcat1524134875052 Disallow: /services/plans/* Disallow: /site/dni/* Disallow: /site/offerbuilder/* Sitemap: https://www.bestbuy.com/sitemap.xml User-agent: GetIntentCrawler Disallow: /

3. Всегда используйте строчные буквы для самого названия файла robots.txt

4. Не используйте никаких специальных символов, кроме * и $. Другие символы поисковыми роботами не распознаются.

5. Создайте отдельные файлы robots.txt для разных поддоменов. Например, Hubspot и Blog.Hubspot имеют отдельные файлы robots.

6. Используйте #, чтобы оставлять комментарии в «роботсах». Боты не распознают строки с маркировкой символом решетки. Пример:

#Google Image Crawler Setup User-agent: CoogLeboE—Image Allow: / skin/ frontend/ default/ MACOSOIBI/ #Crawlers Setup User-agent: * #Directories User-agent: * Disallow: /app/ Disallow: /cgi—bin/ Disallow: /downloader/ Disallow: /includes/ Disallow: /magento/ Disallow: /pkginEo/ Disallow: / shell/ Disallow: /var/ Allow: /skin/ /images/ Allow: /skin/ frontend/ default/ MACOgOIgI /css/ Allow: /skin/ frontend/ default/ MACOgOIgI/js/ Allow: /skin/ frontend/defauIt/MACOgOIgI/products/

7. Помните, что если в файле robots.txt страница запрещена, Google не будет брать во внимание ее SEO вес (даже если обнаружит).

8. НИКОГДА не используйте robots.txt для защиты или блокировки конфиденциальных данных.

Что стоит скрывать в robots.txt?

Файлы robots.txt часто используются для исключения определенных каталогов, категорий или страниц из поисковой выдачи. Для этого используется команда Disallow.

Примеры страниц, которые часто скрывают при помощи файла robots.txt:

- Страницы с дублированным контентом

- Страницы пагинации

- Динамические страницы товаров и услуг

- Страницы аккаунта

- Страницы администратора

- Корзина

- Интегрированные чаты

- Thank you page

Скрытие некоторых типов страниц крайне полезно для e-commerce проектов. Отличный пример файла robots.txt – американский ритейлер одежды Macy’s.

User-agent: * Disallow: /compare Disallow: /registry/wedding/compare Disallow: /catalog/product/zoom.jsp Disallow: /search* Disallow: /shop/search* Disallow: /shop/registry/wedding/search* Disallow: *natuzzi* Disallow: *Natuzzi* Disallow: /bag/add* Disallow: /bag/atbpage* Disallow: /shop/feedback* Disallow: /buy/* Disallow: /my-bag/* Disallow: /shop/*/*/*,*,*/*,*,* noindex: /bag/* noindex: /my-bag/* noindex: /chkout/* noindex: /catalog/* noindex: /shop/b/*/*,*/*,* User-agent: Twitterbot Disallow: * Allow: /shop/product Sitemap: https://www.macys.com/navapp/dyn_img/sitemap/mcom_sitemapindex.xml

Важно!

Не все поисковые роботы ведут себя так, как вы их попросили. Некоторые могут просто нарушать запреты, описанные в robots.txt. Существуют и «плохие ребята» – поисковые роботы, которые полностью игнорируют указанные правила, потому убедитесь, что вы не храните никакой конфиденциальной информации на страницах, которые находятся в рамках команды Disallow.

Распространенные ошибки при формировании robots.txt

Ошибка № 1: Имя файла содержит заглавные буквы

Единственное возможное имя файла — robots.txt. Использовать Robots.txt или ROBOTS.TXT не стоит. Придерживайтесь строчных букв, всегда когда речь заходит о SEO.

Ошибка № 2: Размещать файл robots.txt НЕ в главном каталоге сайта

Если вы хотите, чтобы ваш файл robots.txt был найден, вы должны разместить его в главном каталоге вашего сайта.

Неправильно: www.mysite.com/tshirts/robots.txt

Правильно: www.mysite.com/robots.txt

Ошибка № 3: Некорректный формат User-agent

Неправильно:

Disallow: Googlebot

Правильно:

User-agent: Googlebot Disallow: /

Ошибка № 4: Упоминание нескольких каталогов в одной строке «Disallow»

Неправильно:

Disallow: /css/ /cgi-bin/ /images/

Правильно:

Disallow: /css/ Disallow: /cgi-bin/ Disallow: /images/

Ошибка № 5: Пустая строка в «User-Agent»

Неправильно:

User-agent: Disallow:

Правильно:

User-agent: * Disallow:

Ошибка № 6: Зеркальные сайты и URL в рамках команды host

Будьте осторожны при упоминании host, чтобы поисковые системы правильно вас поняли.

Неправильно:

User-agent: Googlebot Disallow: /cgi-bin

Правильно:

User-agent: Googlebot Disallow: /cgi-bin Host: https://www.site.com

Ошибка № 7: Перечисление всех файлов в каталоге

Неправильно:

User-agent: * Disallow: /pajamas/flannel.html Disallow: /pajamas/corduroy.html Disallow: /pajamas/cashmere.html

Правильно:

User-agent: * Disallow: /pajamas/ Disallow: /shirts/

Ошибка № 8: Отсутствующая строка Disallow

Инструкции Disallow необходимы, чтобы боты поисковой системы понимали что вы хотите им запретить сканировать.

Неправильно:

User-agent: Googlebot Host: www.mysite.com

Правильно:

User-agent: Googlebot Disallow: Host: www.mysite.com

Ошибка № 9: Блокировка всего сайта от поисковых роботов

Неправильно:

User-agent: Googlebot Disallow: /

Правильно:

User-agent: Googlebot Disallow:

Ошибка № 10: Некорректный HTTP header

Неправильно: Content-Type: text/html

Правильно: Content-Type: text/plain

Ошибка № 11: Отсутствующий Sitemap

Всегда размещайте Sitemap в конце файла robots.txt.

Ошибка № 12: Использование Noindex

В 2019 году Google заявил, что больше не будет признавать команду noindex, используемую в robots.txt. Вместо этого рекомендуется использование meta robots tags, о которых речь пойдет ниже.

Неправильно:

User-agent: * Disallow: / Noindex: thank-you

Правильно:

User-agent: * Disallow: thank-you

Ошибка № 13: Ограничить доступ к странице в файле robots.txt, но по прежнему ссылался на нее

Если вы запретите страницу в файле robots.txt, но у вас есть внутренние ссылки, указывающие на нее, Google все равно будет сканировать страницу.

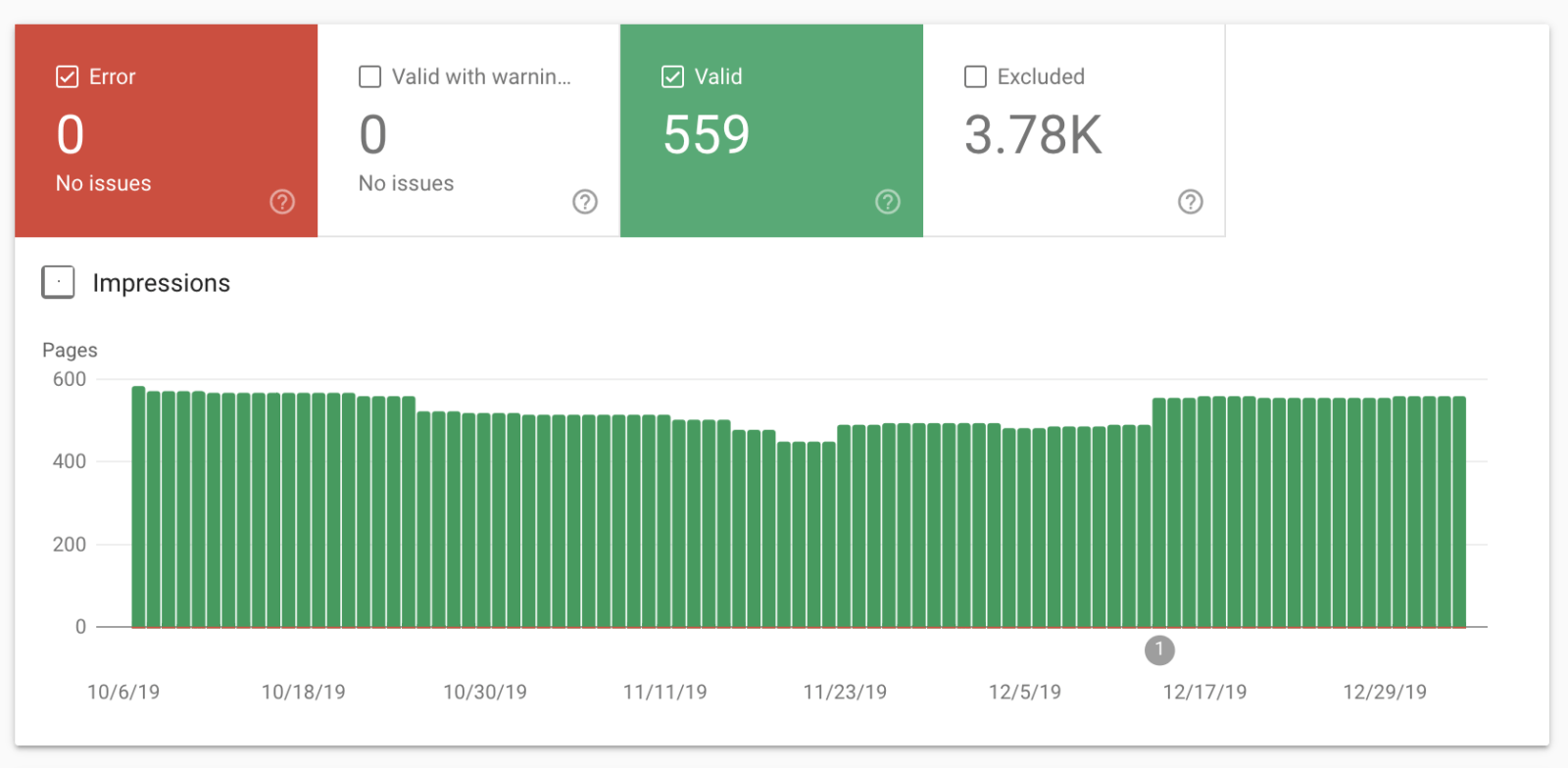

Ссылки на эти страницы нужно удалить, чтобы поисковые роботы не продолжали их сканировать. Если хотите проверить продолжают ли индексироваться страницы – вы можете проверить это в вашем Coverage report через Google Search Console. Выглядит это примерно так:

Также есть официальный инструмент тестирования robots.txt от Google.

Что такое Meta Robots Tags?

Meta robots tags – это фрагменты HTML-кода, которые сообщают роботам как сканировать и индексировать страницы на сайте. Теги мета-роботс добавляются в раздел <head>. Например:

<meta name = ”robots” content = ”noindex” />

Meta Robots Tags состоят из двух частей. Первая часть тега это name = ””. В ней вы определяете user-agent, например Googlebot. Вторая часть тега это content = ””. В ней сообщаете роботам конкретные правила сканирования страницы.

Виды Meta Robots Tags

Существует два типа Meta Robots Tags:

- Meta robots tag

- X-robots-tag

Тип 1: Meta Robots Tag. Они обычно используются SEO-маркетологами. Такой тип тега позволяет указывать какие области страницы сканировать, а какие нет. Например:

<meta name = ”googlebot” content = ”noindex, nofollow”>

Такой тег дает указание роботу Google не индексировать страницу в поисковых системах и не переходить по каким-либо обратным ссылкам. Таким образом, эта страница будет исключена из поисковой выдачи. Крайне удобный тег, который часто используют для thank-you page.

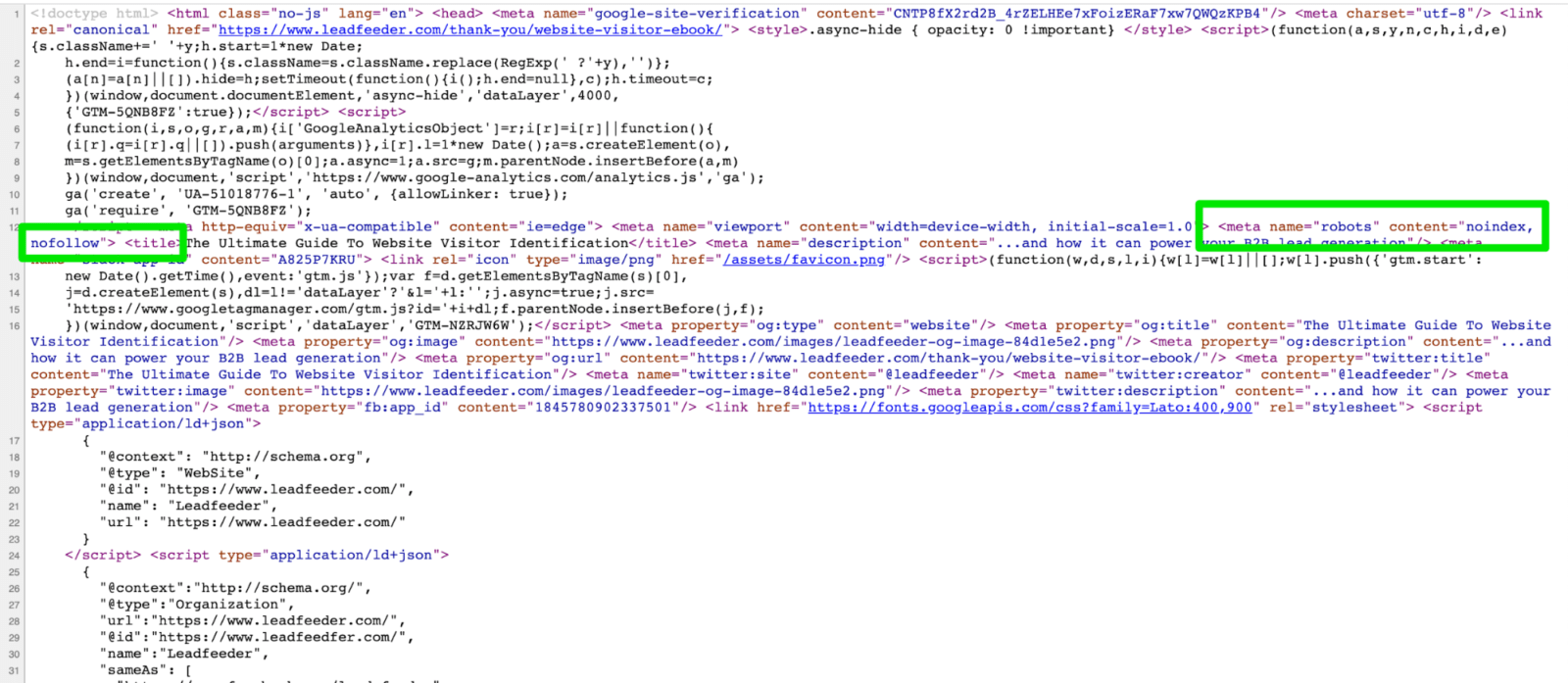

Вот пример кода thank-you page, тег на которой сообщает роботу что нее не нужно сканировать

Крайне важно НЕ размещать meta robot tags за пределами <head>. Почему этого делать не стоит денег может рассказать на конкретном примере Гленн Гейб, “ветеран” диджитал-маркетинга с 20+ лет работы на мировых рынках.

Тип 2: X-robots-tag. Тег x-robots позволяет вам делать то же самое, что и meta robot tags, но не на странице, а в рамках заголовков HTTP-ответов. Это дает значительно больше больше возможностей, чем обычные meta robot tags.

К примеру, вы хотите скрыть от сканирования только изображение или видео на странице, а не всю страницу. Х-robots-tag идеально для этого подходит. Для интеграции x-robots tags вам потребуется доступ к файлам .php, .htaccess или серверу.

Параметры Meta Robots Tag

Вот список самых популярных параметров:

- all – нет ограничений для индексации и содержания, эта директива используется по умолчанию и никак не влияет на работу поисковых систем.

- index – разрешает поисковым системам индексировать страницу в результатах поиска. Тоже работает по умолчанию, ее не нужно добавлять на все страницы.

- noindex – удаляет страницу из индекса поисковых систем и результатов поиска.

- follow – позволяет поисковым роботам пройти по всем внутренним и внешним обратным ссылкам на странице.

- nofollow – запрещает проход по всем внутренним и внешним обратным ссылкам на странице.

- none – работает как сумма noindex и nofollow.

- noarchive – запрещает показывать в поисковой выдаче Saved Copy страницы.

- nosnippet – запрещает показывать сниппет с метаданными страницы в поисковой выдаче.

- notranslate – не предлагает перевод страницы в выдаче.

- noimageindex – запрещает индексировать изображения на странице.

- max-snippet – устанавливает максимальное количество символов в мета-описании.

- max-video-preview – устанавливает количество секунд для предварительного просмотра видео.

- max-image-preview – устанавливает максимальный размер превью изображения.

В некоторых случаях, разные поисковые системы воспринимают разные параметры мета-тегов по разному:

| Value | Bing | Yandex | |

| index | Да | Да | Да |

| noindex | Да | Да | Да |

| none | Да | ? | Да |

| noimageindex | Да | Нет | Нет |

| follow | Да | ? | Да |

| nofollow | Да | Да | Да |

| noarchive | Да | Да | Да |

| nosnippet | Да | Нет | Нет |

| notranslate | Да | Нет | Нет |

| unavailable_after | Да | Нет | Нет |

Как использовать Meta Robots Tags?

Если ваш сайт работает на WordPress, существует множество вариантов плагинов, позволяющих настроить meta robot tags. Наиболее популярным является Yoast. Это универсальный SEO-плагин для WordPress, который предоставляет множество функций. Также существует точечные альтернативы типа Meta Tags Manager или GA Meta Tags.

Для пользователей Joomla, рекомендуется расширение EFSEO или Tag Meta. Но независимо от того, на какой платформе построен сайт, есть три основных совета по использованию этих тегов:

- Помните о чувствительности к регистру. Поисковые системы распознают атрибуты, значения и параметры как в верхнем, так и в нижнем регистре. Но рекомендуется придерживаться строчных букв, в том числе для улучшения читабельности кода.

- Избегайте нескольких тегов <meta> . Использование нескольких тегов может привести к конфликтам. Используйте несколько значений в теге <meta>, например: <meta name = ”robots” content = ”noindex, nofollow”>.

- Не используйте конфликтующие метатеги, чтобы избежать ошибок при индексации. Например, если у вас есть несколько строк кода с метатегами, поисковой робот возьмет во внимание только «nofollow», так как ставит запрещающие значения в приоритет.

<meta name = ”robots” content = ”follow”> <meta name = ”robots” content = ”nofollow”>

Выше показан как раз плохой вариант использования инструментов маркировки.

Как robots.txt и Meta Robots Tags работают вместе?

Одна из самых больших ошибок, которые допускают на рынке – несоответствие файла robots.txt тому, что указано в meta robot tags. Например, файл robots.txt скрывает страницу от индексации, а тег meta robot делает обратное.

Эксперты сходятся во мнении, что в таком случае Google отдает приоритет тому, что запрещено файлом robots.txt. Но лучше не сбивать с толку поисковые роботы и не допускать несоответствий.

Понравился наш гайд? Сообщите нам об этом!